Cyberbezpieczeństwo 2.0: AI może pomóc Ci zwiększyć bezpieczeństwo#

Autor: Tomasz Piłka

Jak sztuczna inteligencja może wzmocnić cyberbezpieczeństwo, ostrzegać użytkowników i pomagać identyfikować zagrożenia#

„AI can help detect threats faster than any human team, and that gives defenders a fighting chance in a constantly evolving battlefield.”

„Sztuczna inteligencja potrafi wykrywać zagrożenia szybciej niż jakikolwiek zespół ludzi, co daje obrońcom realną szansę w stale zmieniającym się cyfrowym polu bitwy.”

— Sundar Pichai, CEO Google

W trackie zajęć uczestnicy zrozumieją, w jaki sposób sztuczna inteligencja jest wykorzystywana do proaktywnego zwiększania bezpieczeństwa cyfrowego, identyfikowania zagrożeń i ochrony danych, a także poznają narzędzia i koncepcje związane z AI w cyberbezpieczeństwie.

AI w Detekcji zagrożeń i rozpoznawaniu phishingu#

Na początku zauważmy, że sztuczna inteligencja (AI) bywa wykorzystywana do generowania spersonalizowanego spamu, deepfake’ów oraz manipulacji treścią. Jednak ta sama technologia może działać jako skuteczny obrońca w walce o bezpieczeństwo w sieci. Wiele osób już dziś korzysta z rozwiązań opartych na AI, które chronią je przed różnorodnymi zagrożeniami, często nawet nie zdając sobie z tego sprawy.

Warto zastanowić się, jakie są najbardziej uciążliwe lub niebezpieczne zagrożenia internetowe, z którymi użytkownicy mogli się spotkać. Równie istotne jest rozpoznanie sytuacji, w których aplikacje, strony internetowe lub systemy informatyczne skutecznie ostrzegły przed zagrożeniem.

Podsumowując, AI można postrzegać jako swoistą tarczę — technologię, która aktywnie chroni użytkowników i ich dane w cyfrowym świecie.

AI w Cyberbezpieczeństwie: Gdzie działa?#

Sztuczna inteligencja to nie tylko „ChatGPT”. To szereg algorytmów, które uczą się na danych i potrafią identyfikować wzorce, przewidywać oraz automatyzować działania. W cyberbezpieczeństwie przekłada się to na konkretne zastosowania:

Sztuczna inteligencja (AI) pomaga nam w ochronie naszych danych i urządzeń dzięki temu, że potrafi szybko i skutecznie analizować ogromne ilości informacji, które dla człowieka byłyby trudne do przejrzenia. AI „uczy się” wzorców i zachowań, dzięki czemu jest w stanie wykryć, gdy coś odbiega od normy — na przykład nietypowe logowanie, podejrzany e-mail lub nowy rodzaj ataku.

Detekcja anomalii i nietypowych zachowań#

Systemy oparte na sztucznej inteligencji (AI) potrafią uczyć się wzorców typowego korzystania z konta lub urządzenia, analizując takie cechy jak godziny logowania, lokalizacje, używane urządzenia czy zwyczaje użytkownika. Dzięki temu są w stanie wykryć nietypowe, podejrzane zachowania — na przykład logowanie z nietypowego miejsca geograficznego (innego kraju), o nietypowej godzinie lub za pomocą nieznanego urządzenia. W momencie wykrycia takiej anomalii AI może natychmiast zareagować: zablokować dostęp, wymagać dodatkowego uwierzytelnienia (np. kodu SMS lub potwierdzenia biometrycznego) albo zaalarmować administratorów systemu. Takie mechanizmy znacząco utrudniają przejęcie konta nawet wtedy, gdy ktoś posiada skradzione hasło, podnosząc ogólne bezpieczeństwo użytkowników.

Analiza zagrożeń (Threat Intelligence)#

Świat cyberzagrożeń jest bardzo dynamiczny — każdego dnia pojawiają się nowe wirusy, ransomware, luki w oprogramowaniu czy zaawansowane ataki typu zero-day. AI, dzięki zdolności przetwarzania i analizowania ogromnych zbiorów danych, pomaga w identyfikacji i klasyfikacji tych zagrożeń na podstawie ich charakterystyk i wzorców działania. Sztuczna inteligencja może prognozować potencjalne wektory ataku oraz rozprzestrzenianie się zagrożeń, co pozwala organizacjom proaktywnie przygotować systemy obronne, aktualizować zabezpieczenia i opracowywać strategie przeciwdziałania — zanim atak faktycznie nastąpi. Taki predykcyjny charakter Threat Intelligence znacząco podnosi efektywność działań z zakresu cyberbezpieczeństwa.

Ochrona przed phishingiem i spamem#

Phishing to jedna z najpowszechniejszych metod ataku, polegająca na podszywaniu się pod zaufane instytucje (np. banki, serwisy czy urzędy) w celu wyłudzenia danych osobowych lub finansowych. AI analizuje szczegółowo cechy wiadomości e-mail — m.in. nagłówki, adres nadawcy, ukryte linki, załączniki oraz samą treść — aby rozróżnić legalne wiadomości od podejrzanych prób phishingu czy spamu. Dzięki temu systemy filtrujące oparte na AI skutecznie eliminują większość niebezpiecznych wiadomości, nie dopuszczając ich do skrzynek odbiorczych użytkowników. Automatyzacja i inteligentne uczenie się pozwalają systemom na ciągłe doskonalenie detekcji nowych, nieznanych wcześniej schematów ataków.

Uwierzytelnianie i biometria#

AI jest szeroko wykorzystywana w nowoczesnych metodach uwierzytelniania, które bazują na unikalnych cechach biologicznych i behawioralnych użytkowników. Systemy rozpoznawania twarzy, głosu czy odcisków palców uczą się indywidualnych wzorców każdej osoby, co pozwala na precyzyjne potwierdzanie tożsamości i znacznie podnosi poziom bezpieczeństwa dostępu do urządzeń i systemów. Dzięki temu tylko uprawnione osoby mogą odblokować telefon, zalogować się do aplikacji czy uzyskać dostęp do chronionych danych. AI potrafi również wykrywać próby oszustwa, np. użycie zdjęcia zamiast prawdziwej twarzy, co zwiększa odporność systemów biometrycznych na manipulacje.

Pytanie do uczestników:

Które z tych zastosowań wydaje się Wam najbardziej innowacyjne lub użyteczne w codziennym życiu?

Zadanie: AI w Akcji – Rozpoznawanie stron phishingowych#

Phishing to popularna forma ataku polegająca na tworzeniu fałszywych stron wyglądających jak prawdziwe, mających na celu wyłudzenie danych użytkowników. AI może wspomóc nas w wykrywaniu takich zagrożeń, ale nie zastąpi uważności i analizy ze strony człowieka.

Otwórzcie w przeglądarce narzędzie VirusTotal pod adresem:

https://www.virustotal.com/gui/home/url

Nauczcie się, jak wklejać adresy URL do skanera i interpretować wyniki:

zielony status „Clean” oznacza brak wykrytych zagrożeń,

czerwony status „Malicious” wskazuje na potencjalne niebezpieczeństwo,

zwróćcie uwagę na raporty różnych silników antywirusowych.

Przeskanujcie najpierw bezpieczny, znany adres, np.

https://www.google.com, aby zapoznać się z działaniem narzędzia.Podzielcie się na pary lub grupy i otrzymacie listę adresów URL do analizy. Nie klikajcie w linki bezpośrednio! Zawsze kopiujcie je i wklejajcie do VirusTotal.

Link 1: autentyczny adres z potencjalnym błędem, np. brak SSL (

http://) lub drobna literówka w domenie (np.facebooc.com), która mimo wszystko prowadzi do prawdziwej strony. AI może tego nie wykryć, dlatego ważna jest Wasza ostrożność.Link 2: przykładowa strona phishingowa (nieaktywna), którą AI powinna oznaczyć jako podejrzaną.

Link 3: prawdziwy, długi i złożony link, np. do artykułu w gazecie, pokazujący, że AI potrafi także analizować skomplikowane adresy.

Analizujcie nie tylko wynik skanera, ale także sam adres URL, obecność certyfikatu SSL (symbol kłódki w przeglądarce) oraz ogólny wygląd i zachowanie strony.

Po zakończeniu pracy podyskutujcie:

Jakie były wyniki skanowania?

Czy AI pomogła w identyfikacji zagrożeń?

Czy zauważyliście elementy, których AI nie wykryła, a które budziły Wasze podejrzenia?

Jakie wnioski wyciągacie na przyszłość, jeśli chodzi o klikanie w linki?

Dzięki temu zadaniu poznaliście praktyczne możliwości i ograniczenia AI w wykrywaniu phishingu oraz nauczyliście się, jak zachować czujność w codziennym korzystaniu z internetu.

AI w wykrywaniu fałszywych treści, walce z manipulacją i ochroną prywatności#

Współczesne technologie oparte na sztucznej inteligencji potrafią generować bardzo realistyczne obrazy, filmy czy teksty, które często trudno odróżnić od autentycznych materiałów stworzonych przez człowieka. W związku z tym powstaje pilna potrzeba rozwijania metod wykrywania takich fałszywych treści, aby chronić użytkowników przed dezinformacją, manipulacją czy oszustwami.

Kluczowe pojęcia i mechanizmy wykrywania fałszywych treści przez AI:#

Analiza metadanych#

Pliki multimedialne, takie jak zdjęcia czy filmy, zawierają ukryte informacje zwane metadanymi — na przykład datę i miejsce wykonania zdjęcia, model aparatu czy ustawienia techniczne. AI może analizować te dane pod kątem spójności i wykrywać anomalie, takie jak brak metadanych lub ich niezgodności, które mogą świadczyć o manipulacji lub fałszywym pochodzeniu materiału.

Wzorce generatywne (ang. generative fingerprints)#

Modele AI, które tworzą treści — teksty, obrazy czy filmy — pozostawiają charakterystyczne ślady lub „odciski palców”. Algorytmy wykrywania uczą się tych wzorców i potrafią rozpoznać, czy dana treść została wygenerowana przez człowieka, czy sztuczną inteligencję. Przykładem takiego podejścia są narzędzia jak ZeroGPT, które oceniają prawdopodobieństwo, że tekst jest dziełem AI.

Cyfrowy watermarking#

Aby ułatwić identyfikację treści generowanych przez AI, niektóre firmy proponują dodawanie niewidocznych znaków wodnych do takich materiałów. Dzięki temu w przyszłości będzie można automatycznie rozpoznać, że dany obraz, film czy tekst został wygenerowany przez sztuczną inteligencję, co ma pomóc w walce z dezinformacją.

Pytanie do uczestników:

Czy uważasz, że AI kiedykolwiek będzie w 100% skuteczna w wykrywaniu deepfake’ów i innych fałszywych treści? Jakie mogą być ograniczenia i wyzwania w tym obszarze?

To zagadnienie stanowi ważny element „wyścigu zbrojeń” między twórcami zaawansowanych deepfake’ów a systemami, które mają je rozpoznawać i chronić użytkowników.

AI jako twórca silnych haseł kontra wsparcie w zabezpieczeniach#

Wielu użytkowników tworzy słabe, przewidywalne hasła, które są łatwe do złamania przez tradycyjne algorytmy. Z kolei bardzo skomplikowane hasła bywają trudne do zapamiętania, co osłabia ich praktyczne zastosowanie. AI może pełnić dwie role — nie jako narzędzie do łamania haseł, ale jako pomoc w generowaniu silnych, unikalnych i jednocześnie łatwych do zapamiętania passphrases.

Ograniczenia tradycyjnych haseł#

Hasła typu Polska2025! czy Zima123# są łatwe do odgadnięcia przy pomocy standardowych metod ataku, jednak dla człowieka są stosunkowo proste do zapamiętania.

AI jako wsparcie w tworzeniu haseł#

AI potrafi wygenerować długie, sensowne i unikalne frazy, które znacznie podnoszą poziom bezpieczeństwa, a jednocześnie są łatwiejsze do zapamiętania niż losowe ciągi znaków. Przykładowe hasła wygenerowane przez AI mogą wyglądać jak absurdalne zdania, np. GłodnaLampaZjadaNiebieskieSchody czy DwaKotyTańcząTangoNaDachu.

Zadanie: Generowanie haseł, a ich wymyślanie#

Otwórzcie chatbota AI (np. ChatGPT, Gemini) i wpiszcie prompt:

Proszę, wygeneruj 5 bardzo bezpiecznych haseł w formie łatwych do zapamiętania, absurdalnych zdań po polsku, składających się z 4-5 słów.Przeanalizujcie wygenerowane propozycje, zwracając uwagę na:

długość i unikalność fraz,

łatwość zapamiętania,

poziom bezpieczeństwa względem typowych ataków.

Porównajcie je z typowymi słabymi hasłami i zastanówcie się, dlaczego takie passphrases mogą być lepszym wyborem.

Refleksja po ćwiczeniu#

W jaki sposób AI pomaga w tworzeniu silniejszych haseł bez konieczności pamiętania skomplikowanych ciągów znaków?

Czy takie absurdalne, długie frazy rzeczywiście są trudniejsze do złamania niż tradycyjne hasła?

Jakie korzyści i ograniczenia widzicie w wykorzystywaniu AI jako narzędzia wspierającego bezpieczeństwo?

To ćwiczenie pokazuje, że AI nie musi być tylko zagrożeniem — może być także efektywnym sojusznikiem w codziennym wzmacnianiu ochrony danych i kont.

Sprawdzanie wiarygodności e-maili i weryfikacja wycieków danych#

W codziennym korzystaniu z poczty elektronicznej często trafiamy na wiadomości podejrzane lub potencjalnie niebezpieczne. Aby chronić się przed phishingiem i innymi zagrożeniami, warto nauczyć się analizować szczegóły techniczne e-maili oraz sprawdzać, czy nasze dane nie znalazły się w wyciekach. AI wspiera nas w tych procesach, analizując ogromne ilości informacji i pomagając podejmować świadome decyzje.

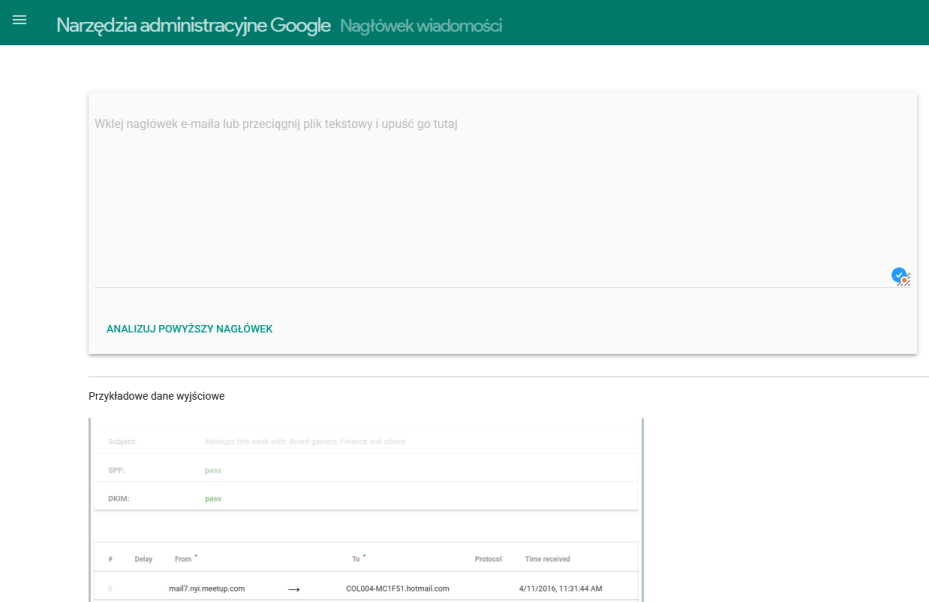

Część A: Analiza nagłówków e-maili#

Znajdowanie nagłówków:

W popularnych klientach pocztowych, takich jak Gmail czy Outlook Web, znajdź opcję „Pokaż oryginał” lub „Pokaż nagłówki” przy wybranej wiadomości.

Skopiuj cały nagłówek wiadomości (to zestaw szczegółowych informacji o trasie i pochodzeniu e-maila).

Analiza nagłówków przy pomocy narzędzia:

Otwórz stronę Google Admin Toolbox - Messageheader.

Wklej skopiowany nagłówek i kliknij „Analizuj”.

Zwróć uwagę na:

Adres IP nadawcy i lokalizację serwera, z którego przyszedł e-mail.

Ścieżkę serwerów (przez które wiadomość była przesyłana).

Wyniki uwierzytelniania SPF i DKIM — potwierdzające, czy nadawca jest uprawniony do wysyłki z danej domeny.

Ćwiczenie 3: Analiza nagłówków własnego e-maila#

Wybierz z własnej skrzynki jeden e-mail, który wydaje się podejrzany (np. z folderu spam).

Skopiuj jego nagłówek i przeanalizuj go za pomocą Google Admin Toolbox.

Ten sam nagłówek wklej do ChatGpt i poproś o wykonanie jego analizy

Zastanów się i omów z grupą:

Co wskazuje na podejrzany charakter wiadomości?

Czy systemy AI w Waszych klientach pocztowych dobrze wykryły potencjalne zagrożenie?

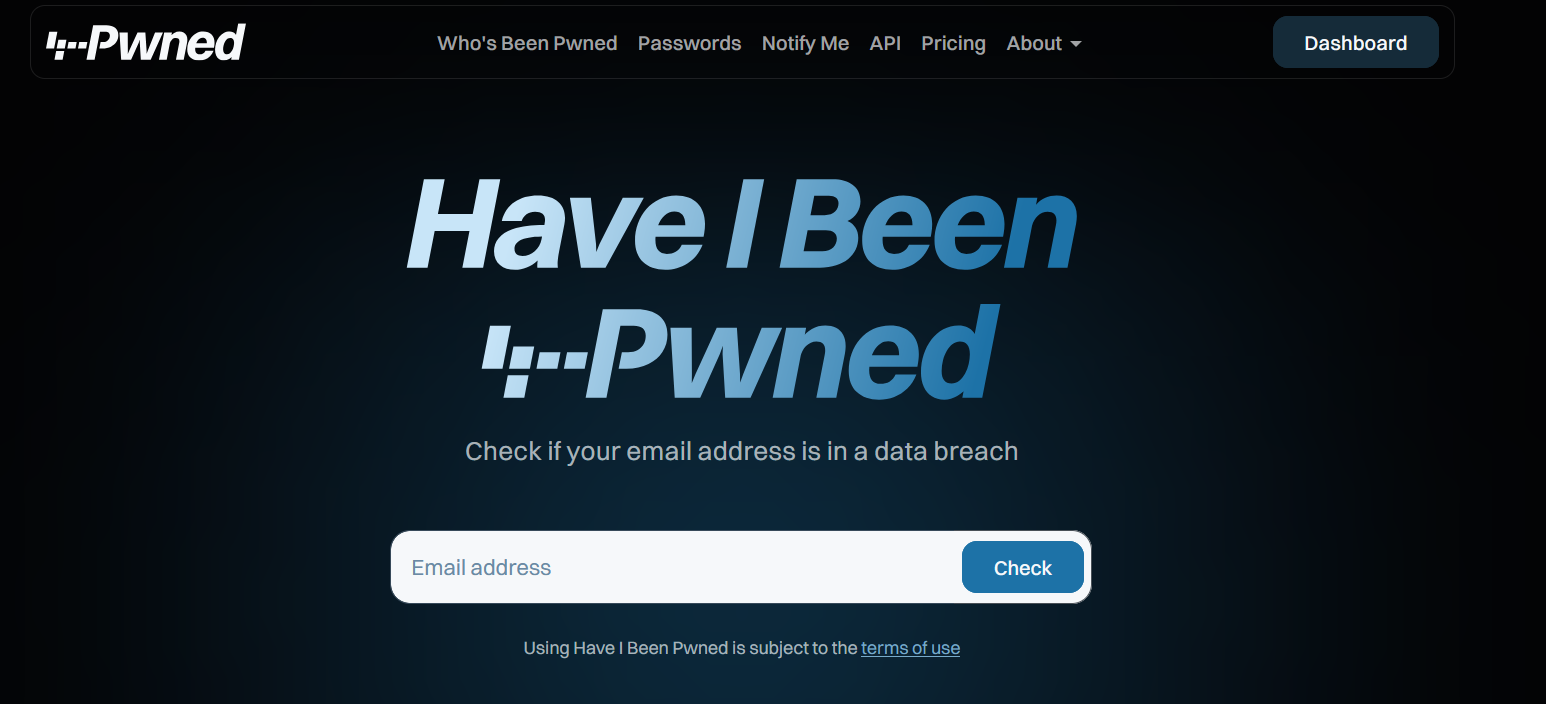

Sprawdzanie wycieków danych#

Co to są wycieki danych?

To sytuacje, w których dane użytkowników (np. adresy e-mail, hasła, numery telefonów) zostają nielegalnie ujawnione i upublicznione w sieci. AI pomaga zbierać te informacje w dużych, stale aktualizowanych bazach danych, które możemy przeszukać, aby lepiej zabezpieczyć swoje konta.

Sprawdzanie za pomocą narzędzia:

Wejdź na stronę Have I Been Pwned?.

Wpisz testowy adres e-mail, np.

test@example.com, aby zobaczyć komunikat o braku wycieków („Good news – no pwnage found!”).Następnie wpisz adres e-mail, który jest Ci znany z wycieków (np. przykładowy adres demonstracyjny), aby zobaczyć szczegóły dotyczące naruszeń.

Praktyczne zadanie:

Każdy uczestnik wpisuje swój główny adres e-mail (lub inny, z którego korzysta do logowania) do narzędzia.

Jeśli adres pojawi się w wyciekach, nie panikuj – to sygnał do natychmiastowej zmiany haseł i wzmocnienia zabezpieczeń w powiązanych serwisach.

Omówcie wspólnie wyniki:

Czy Wasze adresy pojawiły się w wyciekach?

Z jakich serwisów pochodzą ujawnione dane?

Jakie kroki należy podjąć po takim odkryciu, by zwiększyć bezpieczeństwo?

AI odgrywa kluczową rolę w analizie nagłówków e-maili oraz agregacji informacji o wyciekach danych. Dzięki temu możecie szybciej i skuteczniej identyfikować potencjalne zagrożenia i chronić swoje konta. Pamiętajcie, że odpowiedzialne korzystanie z tych narzędzi znacznie podnosi poziom bezpieczeństwa w sieci.

Pytanie do refleksji:

Jakie są największe zalety i ograniczenia korzystania z AI w analizie bezpieczeństwa poczty elektronicznej oraz ochronie przed wyciekami danych?

Zadanie: AI i Analiza prywatności w przeglądarce (Fingerprinting)#

Cel: Zrozumienie, jak dużo danych o nas może zebrać strona internetowa bez naszej wyraźnej zgody i jak AI może te dane analizować do profilowania.

Czas: 20 minut

Instrukcja dla studentów:

Wprowadzenie Prowadzącego: „Kiedy przeglądacie internet, Wasza przeglądarka wysyła o sobie mnóstwo informacji: jaka macie rozdzielczość ekranu, jakie czcionki, wtyczki, strefę czasową. Zestaw tych informacji tworzy unikalny «odcisk palca» (fingerprint) Waszej przeglądarki. AI potrafi analizować te odciski, by śledzić Was bez plików cookie.”

Demonstracja Narzędzia (Prowadzący):

Otwórzcie stronę Panopticlick (EFF) (coveryourtracks.eff.org/).

Kliknijcie „Test Your Browser” i poczekajcie na wyniki.

Omówcie, co oznaczają poszczególne parametry (unikalność odcisku palca, śledzenie).

Zadanie Praktyczne (Studenci):

Niech każdy student uruchomi test na swojej przeglądarce.

Porównajcie wyniki w parach: „Czy Wasze przeglądarki są unikalne? Które elementy najbardziej wyróżniają Wasz «odcisk palca»?”

Dyskusja po Ćwiczeniu (Prowadzący):

„Czy byliście zaskoczeni, ile informacji może zebrać strona internetowa bez Waszej wiedzy?”

„Jak AI może wykorzystać te dane do «profilowania» Was, nawet jeśli nie macie konta na danej stronie?”

„Jakie są metody ochrony przed «fingerprintingiem» (np. przeglądarki z ochroną prywatności, wtyczki)?”

Wyzwania i ograniczenia AI w cyberbezpieczeństwie#

Choć sztuczna inteligencja znacząco wzmacnia ochronę przed cyberzagrożeniami, żadna technologia nie jest pozbawiona wad. Warto poznać i zrozumieć najważniejsze wyzwania i ograniczenia związane z jej stosowaniem w praktyce.

Fałszywe alarmy (False Positives)

AI może błędnie zidentyfikować bezpieczną aktywność jako zagrożenie. Przykładowo, system może oznaczyć ważną wiadomość e-mail jako spam lub zablokować dostęp do konta, gdy użytkownik zaloguje się z nietypowej lokalizacji czy urządzenia. Takie fałszywe alarmy mogą prowadzić do frustracji użytkowników, a nawet utraty dostępu do ważnych zasobów.Fałszywe negatywy (False Negatives)

Jeszcze bardziej niebezpieczne jest przeoczenie prawdziwego zagrożenia. Jeśli AI nie wykryje nowego, dobrze ukrytego ataku lub złośliwego zachowania, użytkownicy i systemy pozostają narażeni na szkody, które mogą mieć poważne konsekwencje finansowe, prawne czy wizerunkowe.Ewolucja zagrożeń i wyścig zbrojeń

Cyberprzestępcy coraz częściej wykorzystują AI do projektowania bardziej zaawansowanych i trudnych do wykrycia ataków, co powoduje dynamiczny wyścig zbrojeń. Systemy obronne oparte na AI muszą się stale rozwijać, aby nadążyć za coraz bardziej wyrafinowanymi metodami ataku.Kwestie prywatności

Aby skutecznie działać, AI potrzebuje ogromnych ilości danych do treningu i analizy zachowań. Masowy zbiór i analiza danych użytkowników rodzi poważne pytania dotyczące prywatności, etyki oraz zgodności z regulacjami prawnymi, takimi jak RODO. Istotne jest znalezienie równowagi między bezpieczeństwem a ochroną prywatności.Bias w danych i decyzjach AI

Jeśli modele uczą się na niepełnych, błędnych lub stronniczych danych, mogą podejmować niesprawiedliwe lub błędne decyzje. W kontekście bezpieczeństwa może to prowadzić do nieprawidłowego klasyfikowania użytkowników lub sytuacji, a nawet do dyskryminacji lub błędów systemowych.

Podsumowanie

Sztuczna inteligencja jest potężnym narzędziem w cyberbezpieczeństwie, ale nie zastąpi w pełni ludzkiego nadzoru. Odpowiedzialne wykorzystanie AI wymaga ciągłego monitoringu, interpretacji wyników oraz zdrowego rozsądku, aby minimalizować ryzyko błędów i nadużyć.

Przyszłość AI w cyberbezpieczeństwie i rola człowieka#

Wizja przyszłości#

Autonomiczne systemy obronne

Przyszłość to systemy AI działające samodzielnie, które potrafią wykrywać i neutralizować zagrożenia w czasie rzeczywistym, bez konieczności stałej ingerencji człowieka. Takie systemy mogłyby reagować na incydenty natychmiast, znacznie skracając czas reakcji i minimalizując szkody.AI w aktywnym wykrywaniu zagrożeń (Threat Hunting)

Zaawansowane systemy analizujące ogromne zbiory danych w poszukiwaniu ukrytych ataków, słabych punktów infrastruktury i podejrzanych wzorców zachowań. AI wspiera w ten sposób ekspertów, pomagając im szybciej i skuteczniej reagować na zagrożenia.Zaawansowane uwierzytelnianie behawioralne

AI uczy się unikalnych cech użytkowników, takich jak sposób pisania, ruchy myszką czy wzorce korzystania z urządzenia. Dzięki temu można precyzyjnie potwierdzić tożsamość, zwiększając bezpieczeństwo i jednocześnie poprawiając komfort użytkowników.

Burza mózgów – nowe zawody w cyberbezpieczeństwie#

Rozwój AI wymusza powstanie nowych specjalizacji i ról w obszarze bezpieczeństwa IT, takich jak:

Inżynierowie promptów – specjaliści odpowiedzialni za tworzenie i optymalizację zapytań do modeli AI, tak by generowały precyzyjne i skuteczne odpowiedzi.

Audytorzy systemów AI – eksperci monitorujący poprawność działania modeli, ich bezpieczeństwo oraz zgodność z wymaganiami prawnymi i standardami.

Eksperci od etyki AI – osoby dbające o to, by systemy AI były wykorzystywane zgodnie z normami etycznymi i społecznymi.

Analitycy cyberzagrożeń z AI – specjaliści wykorzystujący narzędzia AI do analizy zagrożeń i reagowania na incydenty.

Dyskusja nad tym, czy AI odbierze miejsca pracy, czy stworzy nowe możliwości, wskazuje, że raczej zmieni ona rynek pracy, wymuszając rozwój nowych kompetencji i zawodów.

Podsumowanie prowadzącego:

Mimo rosnącej automatyzacji i coraz bardziej zaawansowanych narzędzi AI, kluczowa pozostaje rola człowieka – w nadzorze, tworzeniu, analizie oraz zapewnianiu etycznego i odpowiedzialnego użycia technologii.

Wykorzystanie AI i programowania w cyberbezpieczeństwie#

Prosty klasyfikator w Pythonie#

# Instalacja bibliotek

!pip install scikit-learn pandas

import pandas as pd

from sklearn.feature_extraction.text import TfidfVectorizer

from sklearn.naive_bayes import MultinomialNB

from sklearn.pipeline import Pipeline

from sklearn.model_selection import train_test_split

from sklearn.metrics import classification_report

# Przykładowe dane treningowe

data = {

'text': [

'Pilnie zweryfikuj swoje konto bankowe - kliknij tutaj',

'Twoje konto zostanie zablokowane za 24 godziny',

'Wygraj iPhone - kliknij natychmiast',

'Dzięki za zakupy w naszym sklepie, oto paragon',

'Spotkanie w przyszłym tygodniu zostało przełożone',

'Raport miesięczny w załączniku',

'NATYCHMIAST potwierdź swoją tożsamość!',

'Konto PayPal zostało zawieszone - działaj szybko'

],

'is_phishing': [1, 1, 1, 0, 0, 0, 1, 1]

}

# Tworzenie modelu

df = pd.DataFrame(data)

X_train, X_test, y_train, y_test = train_test_split(

df['text'], df['is_phishing'], test_size=0.3, random_state=42

)

# Pipeline z wektoryzacją i klasyfikacją

model = Pipeline([

('tfidf', TfidfVectorizer(ngram_range=(1, 2))),

('classifier', MultinomialNB())

])

model.fit(X_train, y_train)

# Testowanie

test_messages = [

'Kliknij tutaj aby zweryfikować konto',

'Dziękuję za przesłanie dokumentów',

'PILNE! Twoje konto Netflix zostanie usunięte'

]

predictions = model.predict(test_messages)

probabilities = model.predict_proba(test_messages)

for i, msg in enumerate(test_messages):

risk = "PHISHING" if predictions[i] == 1 else "BEZPIECZNE"

confidence = max(probabilities[i]) * 100

print(f"Wiadomość: {msg}")

print(f"Wynik: {risk} (pewność: {confidence:.1f}%)\n")

Zadanie: Eksploracja AI w detekcji phishingu

Zapoznaj się z przykładowym notebookiem w Google Colab, który prezentuje podstawowe metody wykrywania phishingu za pomocą algorytmów AI. Jak AI rozpoznaje podejrzane wzorce w wiadomościach i spróbuj zrozumieć, jakie cechy są najważniejsze w wykrywaniu fałszywych e-maili/sms .

Link do zasobu:

Google Colab – AI w detekcji phishingu

Eksploracja modeli NLP na platformie Hugging Face*#

Cel:

Poznanie i praktyczne przetestowanie gotowych modeli językowych do detekcji phishingu i spamu.

Instrukcje:

Zadanie, jeśli starczy czasu, wymaga uruchoeminia kodu - np. na platformie Google Colab.

Otwórz stronę: https://huggingface.co/spaces

W polu wyszukiwania wpisz hasła:

"phishing detection"lub"spam detection"Przetestuj dostępne modele, analizując ich działanie na przykładach wiadomości e-mail lub tekstów podejrzanych.

Przykładowe modele do przetestowania:

unitary/toxic-bertmartin-ha/toxic-comment-model

Pytania do refleksji:

Jak modele rozpoznają treści niebezpieczne lub podejrzane?

Jakie ograniczenia mogą mieć gotowe modele w kontekście specyfiki phishingu?

Tworzenie prostego detektora podejrzanych adresów URL#

Zobczmy, jak za pomocą prostego kodu w języku Python, mozemy dokonac analizy cech URL, które mogą wskazywać na phishing lub oszustwo.

Opis zadania:

Przeanalizujcie prostą funkcję w Pythonie, która na podstawie charakterystycznych cech adresu URL będzie oceniać potencjalne ryzyko.

import re

from urllib.parse import urlparse

def analyze_url(url):

"""Prosta analiza URL pod kątem cech phishingowych."""

suspicious_features = []

# Parsowanie URL i pobranie domeny

parsed = urlparse(url)

domain = parsed.netloc.lower()

# Sprawdzanie długości domeny

if len(domain) > 30:

suspicious_features.append("Bardzo długa domena")

# Liczenie myślników w domenie

if domain.count('-') > 3:

suspicious_features.append("Wiele myślników w domenie")

# Sprawdzanie imitacji znanych serwisów

legit_services = ['paypal', 'netflix', 'amazon', 'google', 'microsoft']

for service in legit_services:

if service in domain and not domain.startswith(service + '.'):

suspicious_features.append(f"Imituje {service}")

# Wykrywanie adresu IP zamiast domeny

if re.match(r'^\d+\.\d+\.\d+\.\d+', domain):

suspicious_features.append("Używa adresu IP")

return suspicious_features

# Przykładowe adresy do analizy

test_urls = [

'https://paypal-security.com/verify',

'https://netflix-billing.net/update',

'https://192.168.1.1/phish',

'https://amazon.com/products'

]

for url in test_urls:

features = analyze_url(url)

risk_level = "WYSOKIE" if features else "NISKIE"

print(f"URL: {url}")

print(f"Ryzyko: {risk_level}")

if features:

print(f"Powody: {', '.join(features)}")

print("-" * 50)

Zadanie: Eksploracja AI w detekcji phishingu

Zapoznaj się z przykładowym notebookiem w Google Colab, w którym znajduje się kod do tworzenia prostego detektora podejrzanych adresów URL. Przeanalizuj, jak AI może identyfikować cechy phishingowe na podstawie analizy domeny i wzorców w adresie URL. Spróbuj zrozumieć, które elementy zwiększają ryzyko oraz jak takie reguły można rozbudować.

Link do zasobu:

Google Colab – Prosty detektor phishingu URL i analiza NLP

Analiza socjotechnik z wykorzystaniem ChatGPT jako narzędzia wspierającego#

W dzisiejszym świecie cyberzagrożeń techniki socjotechniczne stanowią jedno z najczęściej wykorzystywanych narzędzi ataku. Są to metody manipulacji psychologicznej, które mają na celu nakłonienie ofiary do ujawnienia poufnych informacji lub wykonania określonych działań na szkodę własną.

ChatGPT może pełnić rolę pomocnika w analizie takich wiadomości, pomagając wykryć:

Techniki psychologiczne wykorzystywane przez atakujących (np. wywoływanie presji czasu, wzbudzanie ciekawości, wykorzystanie autorytetu).

„Czerwone flagi” – charakterystyczne sygnały świadczące o próbie oszustwa, np. nietypowy język, nieprofesjonalne sformułowania, prośby o dane osobowe.

Ocena poziomu zagrożenia na skali od 1 do 10, która pomaga ocenić pilność i ryzyko związane z wiadomością.

Sposoby bezpiecznej reakcji, które można zastosować, by nie paść ofiarą ataku.

Dzięki temu narzędziu nawet osoby bez specjalistycznej wiedzy mogą skuteczniej rozpoznawać próby manipulacji i podejmować świadome decyzje.

Zadanie: Analiza technik socjotechnicznych z pomocą ChatGPT

Zapoznaj się z poniższymi przykładami wiadomości podejrzanych o wykorzystanie socjotechniki. Wykorzystaj ChatGPT jako analizator, korzystając z podanego promptu:

Przeanalizuj poniższą wiadomość pod kątem technik socjotechnicznych. Wskaż: 1. Jakie techniki psychologiczne są używane 2. Czerwone flagi 3. Poziom zagrożenia (1-10) 4. Jak odpowiedzieć bezpiecznie Wiadomość: [WKLEJ PRZYKŁAD]Przykłady do analizy:

Email: „Szanowna Pani, jestem prawniczką z Londynu. Mój klient zmarł i zostawił 2 miliony euro. Ma Pani takie samo nazwisko. Potrzebuję Pani pomocy…”

SMS: „PILNE! Twoje konto PKO zostanie zablokowane za 2 godziny. Kliknij: pkosecurity.com/verify”

Messenger: „Hej! Nie uwierzysz co znalazłem o Tobie w necie… sprawdź: bit.ly/xyz123”

LinkedIn: „Witam, jestem rekruterem z Google. Zainteresowała nas Pani kandydatura. Proszę o CV i dane osobowe na prywatny email…”

Wskazówki do efektywnego korzystania z ChatGPT:

Wklej dokładnie treść analizowanej wiadomości w miejsce

[WKLEJ PRZYKŁAD].Poproś o szczegółowe wyjaśnienie każdego punktu promptu.

Zadawaj dodatkowe pytania, jeśli chcesz lepiej zrozumieć kontekst lub techniki stosowane w wiadomości.

Korzystaj z odpowiedzi ChatGPT jako wsparcia, ale zachowaj krytyczne myślenie i weryfikuj wnioski.

Nie udostępniaj danych wrażliwych podczas testów — korzystaj z przykładów lub anonimowych wiadomości.

Podsumowanie warsztatu#

Przez 90 minut działaliście jak prawdziwy zespół SOC. Nauczyliście się triażować incydenty, rozumieć swój cyfrowy ślad i spojrzeliście na kod, który napędza narzędzia AI. Pamiętajcie, w cyberbezpieczeństwie to nie jest walka «człowiek kontra AI», tylko «człowiek z AI» kontra «atakujący z AI».

10 min – Podsumowanie i Praktyczne Wskazówki: Bądź Swój Własny Obrońca AI (Prowadzący)

Kluczowe przesłanie: „AI jest potężnym sojusznikiem, ale Twoja świadomość i rozsądek to najlepsza linia obrony.”

Praktyczne porady dla studentów (do zapisania):

Używaj uwierzytelniania dwuskładnikowego (2FA): „To prosta, ale bardzo skuteczna bariera.”

Menedżer haseł: „Nie pamiętaj, nie zapisuj, używaj silnych haseł generowanych przez menedżera. AI to doceni!”

Zawsze weryfikuj źródło: „Nie ufaj linkom, e-mailom, czy wiadomościom bez sprawdzenia. Pamiętajcie o narzędziach z dziś.”

Regularne aktualizacje: „Oprogramowanie, system operacyjny, przeglądarka – to łaty na «dziury», przez które AI cyberprzestępców mogłaby się przedostać.”

Sprawdzaj

Have I Been Pwned?regularnie: „Bądź proaktywny w ochronie swoich danych.”Korzystaj z narzędzi AI do skanowania: „Antywirusy, skanery stron – to Twoi cyfrowi strażnicy.”

Chroń swoją prywatność: „Pamiętaj o fingerprintingu. Korzystaj z trybu incognito, VPN, przeglądarek z ochroną prywatności.”

Umiejętności do rozwoju#

Python – wszechstronny język programowania, podstawowy w analizie danych i tworzeniu narzędzi bezpieczeństwa.

Podstawy uczenia maszynowego – kluczowe do zrozumienia automatyzacji w detekcji zagrożeń.

Analiza sieci – umiejętność monitorowania i interpretowania ruchu sieciowego.

Inżynieria promptów – skuteczne formułowanie zapytań do modeli językowych, takich jak ChatGPT, w kontekście analizy incydentów czy automatyzacji raportowania.

Gdzie szukać wiedzy#

Blogi i portale eksperckie:

Krebs on Security – znane źródło analiz ataków i komentarzy branżowych.

The Hacker News – aktualności i analizy zagrożeń.

Dark Reading – materiały o bezpieczeństwie IT i AI.

Cybersecurity Insiders – raporty i trendy.

Platformy edukacyjne i narzędziowe:

Hugging Face – zasoby i tutoriale do pracy z modelami językowymi.

Cybrary – kursy online z cyberbezpieczeństwa, AI i analizy incydentów.

TryHackMe – praktyczne laboratoria i wyzwania związane z bezpieczeństwem.

Certyfikacje i standardy:

CompTIA Security+ – wprowadzenie do podstaw cyberbezpieczeństwa i dobrych praktyk.

Certified Ethical Hacker (CEH) – rozwój umiejętności ofensywnych i defensywnych.

Certified Information Systems Security Professional (CISSP) – szeroka wiedza z zakresu bezpieczeństwa.

NIST Cybersecurity Framework – wytyczne i standardy bezpieczeństwa.

Książki i materiały klasyczne:

„Artificial Intelligence in Cybersecurity” – przegląd zastosowań AI w ochronie systemów.

„Cybersecurity and Applied AI” – praktyczne aspekty wdrażania AI w ochronie IT.

„Security Engineering” Bruce Schneier – klasyka bezpieczeństwa, ważna także w kontekście AI.

Publikacje IEEE i ACM dotyczące AI i bezpieczeństwa.

Społeczności i konferencje:

OWASP – organizacja skupiająca się na bezpieczeństwie aplikacji i narzędziach.

Udział w konferencjach takich jak DEF CON, Black Hat, RSA Conference.

Grupy LinkedIn i Slack skupiające specjalistów AI w cyberbezpieczeństwie.

Fora dyskusyjne typu Stack Exchange (Security Stack Exchange).

Materiały do samodzielnego eksperymentowania:

Publiczne dataset’y np. CICIDS, MalwareBazaar, VirusTotal

Platformy do testów bezpieczeństwa z wykorzystaniem AI, np. sandboxy, honeypoty.

Narzędzia do analizy logów i sieci z AI, np. ELK Stack, Splunk z dodatkami AI.

Dzięki tym zasobom możesz rozwijać swoje kompetencje i przygotować się na efektywne współdziałanie z AI w roli obrońcy cyberprzestrzeni.

Zakończenie#

Zauważmy, że niezależnie od firmy technologicznej, osoby odpowiedzialne za kierunki jej rozwoju widzą ogromne znaczenie i szansę w wykorzystaniu sztucznej inteligencji jako wsparcia w przeciwdziałaniu atakom cybernetycznym:

„As cyber threats grow more sophisticated, artificial intelligence is becoming not just a helpful tool, but a necessary shield.”

„W obliczu coraz bardziej wyrafinowanych zagrożeń cybernetycznych, sztuczna inteligencja staje się nie tylko użytecznym narzędziem, lecz konieczną tarczą.”

— Brad Smith, prezes Microsoft